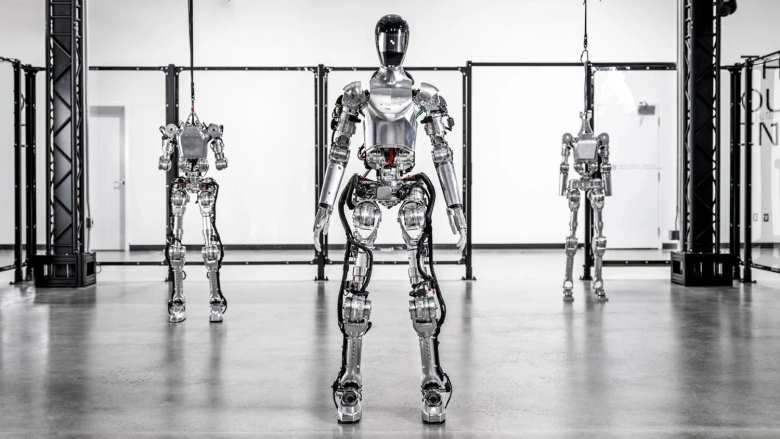

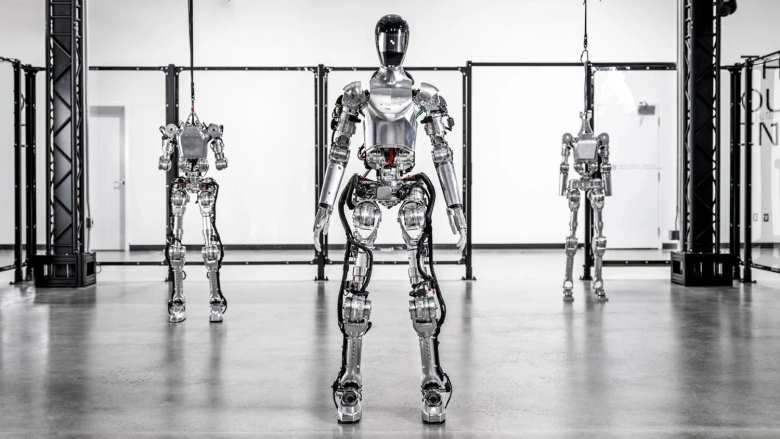

L’inizio della fine per gli esseri umani è vicino. Figura 01, un robot umanoide dotato dell’intelligenza artificiale di OpenAI.ha dimostrato capacità di ragionamento visivo e di comprensione del linguaggio. Affidandosi alle reti neurali, i suoi creatori sono riusciti a fargli compiere azioni e a rispondere con una voce sintetica.

Il robot nasce da un’idea di Figure, un’azienda di intelligence che cerca di “estendere le capacità umane” attraverso un’intelligenza artificiale avanzata. L’azienda mira a “rivoluzionare la catena di produzione” con robot umanoidi in grado di svolgere lavori non sicuri o indesiderati. In questo modo, tutti noi condurremmo una vita più felice e più ricca di obiettivi.

Per arrivare a questo futuro, Figure ha firmato un accordo con OpenAI per integrare la sua intelligenza artificiale nella Figura 01. Con questo, il robot sarebbe in grado di comprendere il linguaggio e di agire di conseguenza.e potrebbe essere integrato come lavoratore in una fabbrica.

L’azienda ha mostrato il primo frutto di questa collaborazione in una dimostrazione video. In esso, il Figura 01 risponde a una serie di comandi con azioni specifiche.. Il robot umanoide è in grado di identificare gli oggetti di fronte a sé e di comprendere il linguaggio della persona con cui interagisce.

– Figura 01, cosa vedi ora?

– Vedo una mela rossa su un piatto al centro del tavolo, uno scolapasta con piatti e bicchieri e lei in piedi vicino con una mano sul tavolo.

Quando gli viene chiesto qualcosa da mangiare, la Figura 01 dà la mela alla persona e spiega che l’ha fatto perché è l’unico cibo sul tavolo. Tutto questo mentre mette i rifiuti in una scatola di plastica. Successivamente, esegue un esercizio di ragionamento ponendo i bicchieri e i piatti nello scolapasta, seguito da un’autovalutazione della propria prestazione.

Secondo Brett Adcock, il fondatore di Figure, il robot Figure 01 esegue azioni per mezzo di reti neurali da un capo all’altro. La dimostrazione è stata registrata in tempo reale e non c’è teleoperazione.

“Le telecamere integrate sono alimentate da un grande modello di linguaggio visivo (VLM) addestrato da OpenAI”, ha detto Adcock. “Le reti neurali riprendono le immagini a 10 Hz attraverso le telecamere del robot. La rete neurale genera poi azioni a 24 gradi di libertà a 200 Hz”.

Come funziona Figure 01, il robot alimentato dall’intelligenza artificiale di OpenAI che reagisce come un essere umano

Corey Lynch, direttore del settore AI dell’azienda, ha spiegato che tutti i comportamenti del robot vengono appresi ed eseguiti a velocità normale. Lynch, che è anche leader del progetto Figure 01, ha rivelato che l’intelligenza artificiale di OpenAI prende le immagini dalle telecamere e trascrive in testo le istruzioni catturate in audio dai microfoni del robot.

“Il modello elabora l’intera storia della conversazione, comprese le immagini passate, per generare risposte linguistiche, che vengono trasmesse all’uomo attraverso il text-to-speech”, ha detto Lynch. in un post su X (Twitter). “Lo stesso modello è responsabile di decidere quale comportamento appreso eseguire sul robot per eseguire un determinato comando, caricando il compito delle reti neurali sulla GPU ed eseguendo una politica”.

Lynch spiega che il modello OpenAI consente al robot di descrivere il proprio ambiente e di utilizzare il ragionamento di senso comune. per prendere decisioni. L’intelligenza artificiale gli conferisce anche la capacità di comprendere richieste ambigue e di agire di conseguenza. Ma tutto questo non sarebbe possibile senza l’integrazione delle reti neurali per generare i movimenti.

Tutti i comportamenti sono guidati dalle politiche visuomotorie delle reti neurali, che mappano i pixel direttamente alle azioni. Queste reti acquisiscono immagini integrate a 10 Hz e generano azioni a 24 gradi di libertà (posture del polso e angoli delle articolazioni delle dita) a 200 Hz.

Corey Lynch

A grandi linee, la Figura 01 funziona come segue.

- Il modello OpenAI esegue il ragionamento e progetta un piano.

- Le politiche apprese dalla rete neurale eseguono il piano attraverso movimenti rapidi e reattivi, affidandosi a un controller del corpo intero per mantenere l’equilibrio.

“Qualche anno fa avrei pensato che per avere una conversazione con un robot umanoide mentre pianifica ed esegue i propri comportamenti completamente appresi avremmo dovuto aspettare decenni.” ha detto Lynch. “Ovviamente, molte cose sono cambiate.