L’industria dell’intelligenza artificiale potrebbe consumare tanta energia quanto un paese delle dimensioni dei Paesi Bassi o dell’Irlanda, avverte un nuovo studio. Questo, quando si diffonderà su larga scala, , che l’autore dell’analisi stima per il 2027.

La ricerca è stata condotta da Alex De Vries, dottorando presso la VU Amsterdam School of Business and Economics. È anche il fondatore di Digiconomist, una società che si occupa di svelare le conseguenze indesiderate delle tendenze digitali. De Vries ha preso in considerazione diversi parametri, come il tasso di crescita di questa tecnologia, la disponibilità di chip di intelligenza artificiale e il dispendio energetico dei server fino ad oggi.

ChatGPT è stata la causa scatenante di tutto. Da quando il famoso chatbot ha fatto il suo ingresso sul mercato lo scorso novembre, i giganti della tecnologia come Microsoft e Google hanno concentrato i loro sforzi per perfezionare i propri strumenti di intelligenza artificiale. Il tutto a una velocità frenetica, con il conseguente impatto ambientale.

Un altro studio ha rivelato in aprile che le aziende utilizzavano una quantità impressionante di acqua dolce per raffreddare i server collegati a prodotti come ChatGPT. L’addestramento di GPT-3 – uno dei modelli alla base di ChatGPT – nei data center statunitensi di Microsoft ha consumato direttamente ben 700.000 litri di acqua dolce pulita. È quanto servirebbe, ad esempio, per produrre 370 automobili BMW o 320 veicoli elettrici Tesla.

La ricerca di De Vries, che è stata sottoposta a revisione paritaria e pubblicata sulla rivista Jouleosserva che il consumo di energia elettrica nei data center ha rappresentato in modo relativamente stabile l’1% del consumo globale di energia elettrica. Tra il 2010 e il 2018, il consumo sarebbe aumentato solo del 6%. Il timore è che l’intelligenza artificiale provochi ora un’impennata di questi consumi.

Quanta energia può richiedere l’uso dell’intelligenza artificiale?

De Vries ha preso come riferimento che GPT-3 ha consumato circa 1.287 MWh di elettricità nella sua fase di addestramento. Gopher e Open Pre-trained Transformer, altri sviluppatori, hanno utilizzato rispettivamente 1.066 MWh e 324 MWh. Ma la spesa energetica rimane monumentale anche dopo lo sviluppo iniziale.

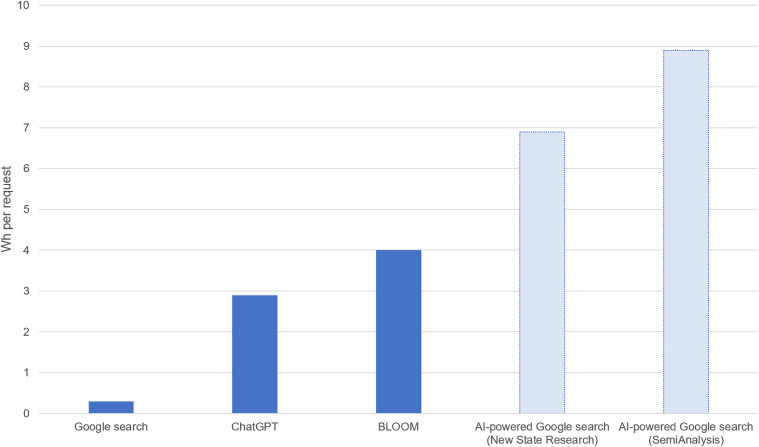

Lo studio rileva che ChatGPT risponde a circa 195 milioni di richieste al giorno. Ciò richiede un consumo medio di elettricità stimato in 564 MWh al giorno. O, al massimo, 2,9 wattora (Wh) per richiesta.

Un’altra importante variabile presa in considerazione è l’utilizzo di chip Nvidia. De Vries stima che l’azienda fornirà circa il 95% del kit di elaborazione AI richiesto dal settore entro il 2027. Si tratta sostanzialmente della stessa percentuale che alcuni analisti attribuiscono attualmente a Nvidia nel settore.

Per anni Nvidia ha prodotto unità di elaborazione grafica (GPU) destinate all’esecuzione di videogiochi. Ora questi stessi chip vengono utilizzati per eseguire i potenti algoritmi alla base dei sistemi di intelligenza artificiale. ChatGPT e altri modelli di OpenAI, ad esempio, sono stati sviluppati utilizzando un supercomputer fornito da Microsoft che utilizza un sistema di elaborazione grafica. circa 10.000 di queste GPU.

NVIDIA potrebbe spedire circa 1,5 milioni di unità entro il 2027.anche se la sua quota di mercato dovesse diminuire, come previsto. De Vries stima che, in base al consumo di queste unità, si possa ipotizzare un utilizzo di energia elettrica compreso tra 85 e 134 terawattora (TWh) al giorno per mantenere in funzione i sistemi di intelligenza artificiale. Nel peggiore dei casi, si tratta di una quantità di energia pari a quella utilizzata da un intero Paese.

“Stiamo parlando delle dimensioni di un Paese come i Paesi Bassi in termini di consumo di elettricità. Stiamo parlando di circa mezzo punto percentuale del nostro consumo totale di elettricità a livello mondiale”, ha dichiarato De Vries al BBC.

Solo Google consumerebbe tanta energia quanto l’Irlanda

Google ha già incorporato l’intelligenza artificiale in diversi suoi strumenti, come Gmail, Foto e altre applicazioni del Worskpace. Ha anche lanciato Bard, la sua versione di ChatGPT. Cosa succederebbe se ogni query standard sul motore di ricerca più usato al mondo fosse alimentata dall’intelligenza artificiale?

Il consumo totale di elettricità di Google è stato di 18,3 TWh nel 2021. L’intelligenza artificiale rappresenterebbe allora una quota compresa tra 10% al 15% del consumo totale di energia elettrica.. “Lo scenario peggiore suggerisce che la sola intelligenza artificiale di Google potrebbe consumare tanta elettricità quanto un Paese come l’Irlanda”, sottolinea l’analisi di De Vries.

Il presidente di Alphabet, John Hennessy, ha dichiarato a Reuters a febbraio che interagire con un modello linguistico di grandi dimensioni (LLM) potrebbe “probabilmente costare 10 volte di più di una ricerca standard con parole chiave”. Una ricerca su Google consuma 0,3 Wh di elettricità. In questo caso, il calcolo per ogni ricerca guidata dall’intelligenza artificiale sarebbe di 3 Wh.

SemiAnalisi ha stimato che l’implementazione di un’intelligenza artificiale simile a ChatGPT su ogni ricerca di Google richiederebbe un totale di 4.102.568 GPU. Con una richiesta di 6,5 kW per server, ciò si tradurrebbe in un consumo giornaliero di 80 GWh. E quindi un consumo annuale di 29,2 TWh.. Tuttavia, chiarisce De Vries, questo scenario presuppone un’adozione su larga scala dell’intelligenza artificiale utilizzando l’hardware e il software attuali, cosa che a suo avviso è improbabile che avvenga in tempi brevi.

La ricerca di alternative

L’utilizzo di tanta energia è molto costoso. Per questo motivo gli sviluppatori sono da tempo alla ricerca di alternative. “Se riusciamo a ridurre il costo dell’intelligenza e il costo dell’energia, la qualità della vita per tutti noi aumenterà incredibilmente”, ha dichiarato a maggio Sam Altman, leader di OpenAI, il creatore di ChatGPT.

Altman è anche uno dei principali investitori di Helion, che a maggio ha firmato un accordo con Microsoft per la fornitura di energia elettrica a partire dal 2028 dalla fusione nucleare. “È necessario rendere i sistemi di intelligenza artificiale sempre più potenti spendendo sempre meno”, ha dichiarato Altman. sul nuovo accordo.

Anche OpenAI sta cercando da mesi un’alternativa ai costosi e scarsi chip di Nvidia. Altri, come Microsoft, Intel e Meta, hanno fatto la stessa ricerca, con l’obiettivo di produrre i propri chip.

Ma De Vries avverte: “È probabilmente troppo ottimistico aspettarsi che i miglioramenti nell’efficienza dell’hardware e del software compensino completamente qualsiasi cambiamento a lungo termine”. Questi sviluppi possono anche innescare un effetto di rimbalzo.. Secondo il rapporto, “una maggiore efficienza porta a una maggiore domanda”, aumentando invece di ridurre l’uso complessivo delle risorse.