La crescente popolarità degli strumenti di generazione di testi e immagini che utilizzano algoritmi di intelligenza artificiale rappresenta una minaccia diretta agli interessi di qualsiasi governo totalitario. Per loro, il controllo sulle informazioni a cui la nazione può accedere è fondamentale. Tuttavia, il compito sta diventando sempre più complicato: prima internet, poi i social media, e ora l’intelligenza artificiale che genera le deepfakes.

Per questo motivo, a dicembre l’Amministrazione del Cyberspazio cinese ha approvato una nuova serie di leggi che regolamentano la tecnologia che utilizza tecniche di apprendimento automatico, realtà virtuale e qualsiasi altro tipo di algoritmo in grado di generare artificialmente immagini, audio, video o scene virtuali. Queste misure entrano in vigore questo mese.

Per il governo cinese, internet è sempre stato pericoloso

Non c’è da sorprendersi. Il Partito Comunista Cinese ha supervisionato rigorosamente ciò che può essere visto e pubblicato su Internet sin dalla sua espansione. L’Internet cinese non è l’Internet in cui voi e io navighiamo ogni giorno e il suo utilizzo non è anonimo, poiché ogni cittadino deve collegare il proprio numero di telefono associato alla carta d’identità. Inoltre, ogni social network è monitorato e moderato dal Partito grazie ad algoritmi di intelligenza artificiale che impediscono la promozione di notizie, opinioni o modi di vita contrari alla visione del Partito.

I nuovi regolamenti vieta la creazione o la diffusione di “fake news” generate da tali strumenti o di informazioni “dannose per l’economia o la sicurezza nazionale”. Questa ponderata ambiguità offre alle autorità un ampio margine di interpretazione per censurare quasi ogni tipo di contenuto. Inoltre, obbliga le aziende responsabili di queste tecnologie a etichettare “in modo evidente” le immagini, i video e i testi come generati “sinteticamente”, come si suol dire deepfakes quando possono essere interpretati erroneamente come reali. Indipendentemente dal contenuto o dallo scopo del materiale generato, il cittadino deve sapere in ogni momento che si tratta di qualcosa prodotto da un computer.

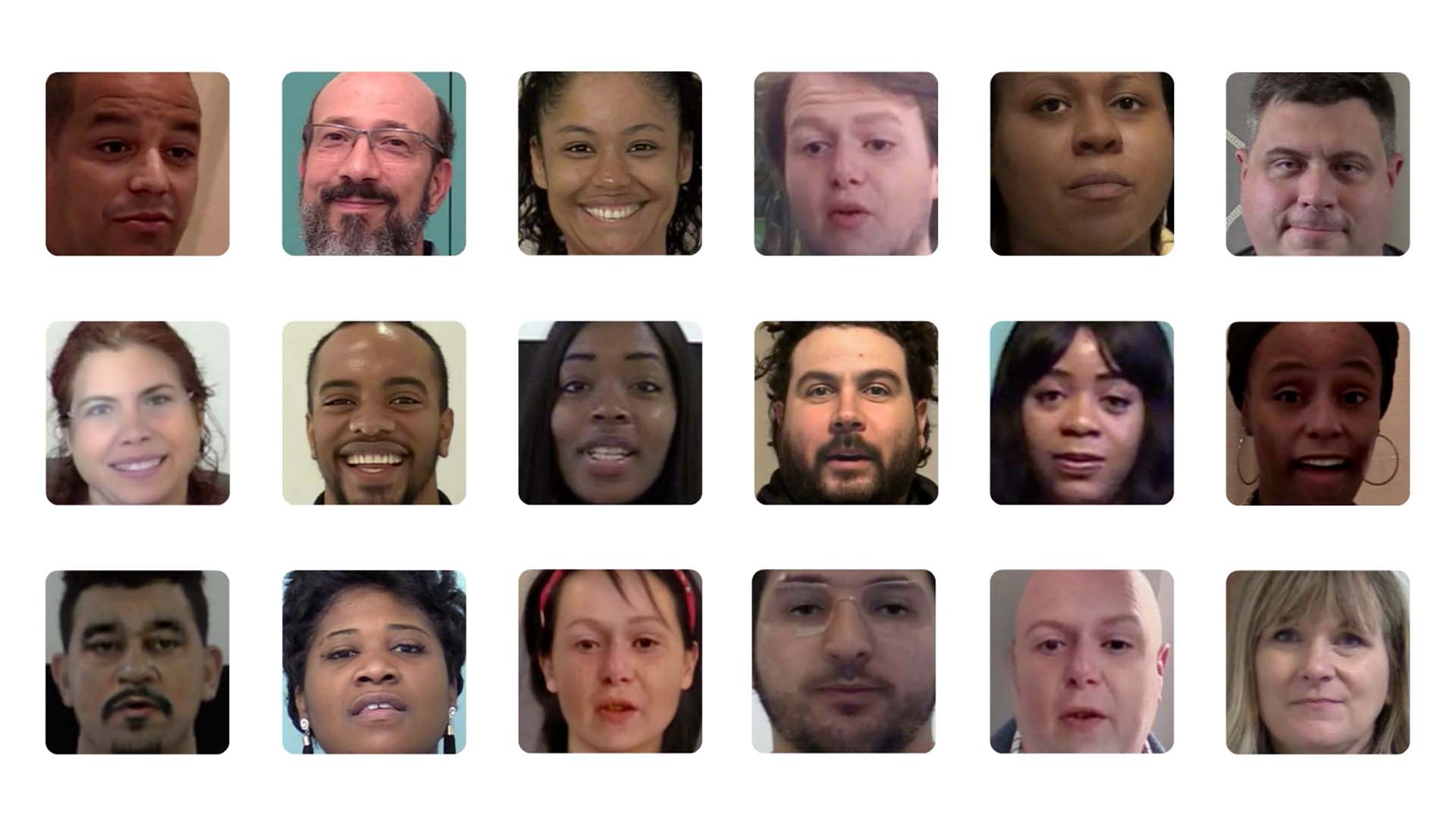

La Cina osserva ciò che accade in Occidente e prende precauzioni prima che questo rappresenti un problema serio per il governo. Dal 2014, una serie di individui e organizzazioni hanno flirtato con con l’idea di generare deepfakes deepfakes realistici grazie all’intelligenza artificiale. Il suo primo utilizzo, come è diventato comune su Internet, è stato la creazione di materiale pornografico utilizzando volti noti di donne famose del cinema, dell’industria musicale o della politica senza il loro consenso. Tecnologie simili sono state presto adottate per scopi meno riprovevoli sotto forma di filtri all’interno di Snapchat o TikTok.

Le prestazioni degli algoritmi e la facilità d’uso di questi strumenti hanno reso possibile la creazione di audio, immagini e persino video realistici in grado di manipolare il discorso di un politico in modo da fargli dire apparentemente ciò che non ha detto.

I progressi più significativi sono stati compiuti negli Stati Uniti, ma le aziende cinesi stanno già sviluppando i propri algoritmi che attingono alla cultura cinese, poiché strumenti come DALL-E 2 e ChatGPT sono chiaramente influenzati dalla cultura e dall’industria anglosassone, che ha poco a che fare con la cultura orientale o con la visione etica e sociale del Partito Comunista Cinese. Non si tratta solo di controllare l’IA, ma di svilupparne una propria, in linea con i propri valori, per poter competere a livello globale con le altre nazioni.

Cosa può succedere negli Stati Uniti

Negli Stati Uniti la questione è più complicata perché il governo non ha un controllo assoluto su Internet. La sfida consiste nel regolamentare gli usi potenzialmente dannosi di queste tecnologie senza violare le forme legittime di espressione protette dal Primo Emendamento e dalla Dichiarazione universale dei diritti umani. Un cittadino ha il diritto di avere informazioni accurate, ma anche il diritto di creare contenuti satirici o di esprimere liberamente opinioni o idee creative.

Ma l’uso di deepfakes Il contenuto presenta problemi importanti, come la manipolazione del pubblicola creazione di materiali che violano il diritto all’onore dei cittadini, le violazioni del diritto d’autore o della proprietà intellettuale…

Virginia, Texas e California hanno già proposto misure. In Virginia, la legge criminalizza chiunque distribuisca materiale pornografico non consensuale utilizzando la tecnologia. deepfake e il Texas proibisce anche la distribuzione di tali documenti generati con l’intento di diffamare o danneggiare la reputazione di candidati politici. Tuttavia, non c’è un chiaro consenso su come legiferare per proteggere tutti i cittadini senza limitare i loro diritti costituzionalmente protetti.

Secondo Aaron Moss, responsabile del dipartimento di contenzioso dello studio legale Greenberg Glusker, le celebrità hanno avuto un certo successo nel citare in giudizio gli inserzionisti per l’uso non autorizzato delle loro immagini in base alle leggi sul cosiddetto diritto di pubblicità. Ha citato l’accordo di 5 milioni di dollari tra Woody Allen e American Apparel nel 2009 per l’apparizione non autorizzata del regista su un cartellone pubblicitario dell’audace marchio di abbigliamento.

Le grandi aziende di IA come OpenAI potrebbero filigranare ogni immagine o video generato, ma ciò comprometterebbe chiaramente il suo valore artistico o commerciale. La protezione contro l’uso improprio di questi strumenti pregiudica la possibilità di utilizzarli al meglio.

Inoltre, questo approccio non risolve i problemi di generazione del testo, che stanno già causando grattacapi ai professori universitari. Lo studente ha scritto quel saggio o è stato ChatGPT? Lo strumento sta ancora strisciando, ma scrive già meglio di molte persone e si presenta come un’entità apparentemente razionale quando non è altro che un calcolatore di previsioni per la scelta della parola successiva.

Armi contro deepfakes in Europa

Nel quadro europeo, ogni cittadino può contare sul diritto alla protezione dei dati personali. Il primo paragrafo dell’articolo 5 del Regolamento generale sulla protezione dei dati (RGPD) stabilisce che qualsiasi contenuto online relativo a una persona deve essere “corretto e trasparente nei confronti dell’interessato” e che deve essere “accurato e, se necessario, aggiornato”. In caso contrario, l’articolo stabilisce che “devono essere adottate misure ragionevoli per cancellare o rettificare senza indugio i dati personali inesatti rispetto alle finalità per le quali sono trattati”.

L’approvazione in aprile del Digital Services Act (DSA), che mira a sottoporre le principali aziende tecnologiche a una maggiore responsabilità per i contenuti illegali diffusi sulle loro piattaforme e servizi, fornisce ancora più risorse all’Unione Europea per combattere la disinformazione e i contenuti illegali. deepfakes. I principali social network dovranno rimuovere immediatamente tutti i contenuti falsi per fermare la disinformazione e la violazione dell’onore dei cittadini. In caso contrario, dovranno affrontare pesanti sanzioni che possono arrivare fino al 6% del loro fatturato globale.

Credito: Parlamento europeo

Credito: Parlamento europeoGià nel 2020, Twitter ha iniziato a taggare e cancellare i video realizzati artificialmente con lo scopo di manipolare le informazioni o impersonare una persona senza il suo consenso. Tuttavia, la diffusione di questi materiali è sempre più veloce della loro cancellazione. Un discorso video manipolato di un politico, impossibile discernere se si tratta di un falso o menopuò mettere sotto scacco la società che gestisce il social network, le autorità e i giudici.

Quando l’intelligenza artificiale eclisserà l’occhio e la comprensione umana, sarà difficile controllare ciò che è veritiero e ciò che non lo è e, soprattutto, farlo in tempo, prima che il danno sia già fatto.

La soluzione più praticabile sembra essere quella di sottoporre questi algoritmi alla loro stessa medicina: altri algoritmi, ma che, invece di essere addestrati a ingannare, siano addestrati a rilevare l’inganno. Per un essere umano può essere difficile capire se un’immagine è fatta da un robot o da un sosia, ma per una macchina è relativamente facile verificarlo, dato che si tratta di processi matematici. Non solo esistono già programmi per il rilevamento di testi generati da ChatGPT, ma anche ci sono quelli che rilevano se una voce è umana o generata sinteticamente.

Tuttavia, se oggi dobbiamo creare un’IA per controllare l’IA che abbiamo programmato ieri, dove andrà a finire l’essere umano di domani se non è già in grado di controllare ciò che lui stesso ha creato?