Dall’esplosione dell’intelligenza intelligenza artificialeI governi di tutto il mondo stanno accelerando i tempi per cercare di controllare una tecnologia e un’industria che sta diventando sempre più potente. Ci sono molti progetti di legge, con approcci molto diversi, ma un nuovo studio dell’Università di Cambridge ritiene che il modo più efficace sia quello di controllare un elemento chiave della tecnologia: i chip.

Nel analisipubblicata questa settimana, comprende esperti di altre università, come Harvard e Oxford, e alcuni specialisti di OpenAI, il creatore di ChatGPT. Il gruppo propone misure che vanno dal monitoraggio di della distribuzione dei chip, alla possibilità di creare un interruttore per sospendere da remoto questi dispositivi.

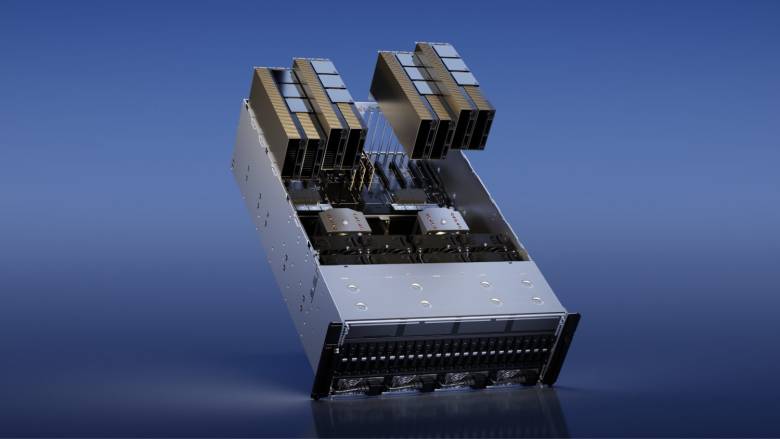

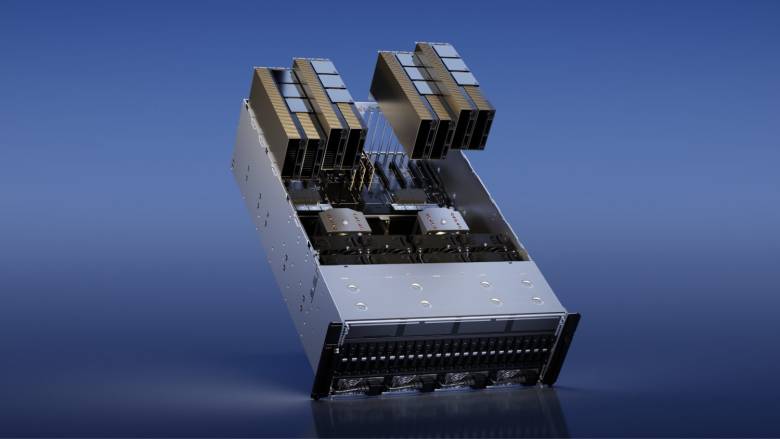

“L’informatica legata all’intelligenza artificiale è un punto di intervento particolarmente efficace: è rilevabile, escludibile e quantificabile, e avviene attraverso una filiera estremamente concentrata”, affermano gli esperti nel rapporto. Ciò è in contrasto con la complessità del tentativo di regolamentare i risultati di sviluppi quali algoritmi o modelli addestrati. “Si tratta di beni intangibili, non rivali e facilmente condivisibili, il che li rende intrinsecamente difficili da controllare”.

L’analisi sottolinea che, al momento, chip avanzati che vengono utilizzati per addestrare i sistemi di intelligenza artificiale sono prodotti da un gruppo molto ristretto di attori. Nvidia, ad esempio, controlla quasi il 90% di questo mercato. “Ciò consente ai responsabili politici di limitare la vendita di questi prodotti a persone o Paesi di loro interesse.“, sottolineano.

I pro e i contro di un pulsante per disattivare l’intelligenza artificiale

Gli esperti hanno proposto misure pratiche, come l’implementazione di un registro globale per le vendite di chip di intelligenza artificiale. La misura consentirebbe di tracciare questi componenti durante il loro ciclo di vita in qualsiasi parte del mondo. Per tale registro, i ricercatori propongono l’incorporazione di un identificatore unico per ogni chip. Ciò impedirebbe, ad esempio, il traffico illegale.

Misure come queste aumenterebbero la visibilità e la comprensione degli sviluppi dell’intelligenza artificiale da parte dei politici. Gli esperti sottolineano che la visibilità è “cruciale”, perché consentirà ai governi di “anticipare i problemi, prendere decisioni più accurate, monitorare i risultati all’interno di un Paese e negoziare e attuare accordi tra Paesi”.

Negli Stati Uniti sono stati compiuti alcuni progressi in questo senso. Lo studio cita come esempio l’iniziativa del Presidente Joe Biden dello scorso anno di di identificare tutte le aziende che stanno sviluppando modelli di grandi dimensioni di intelligenza artificiale. Oppure la posizione del Dipartimento del Commercio degli Stati Uniti, che ha inasprito le limitazioni sulla vendita di acceleratori alla Cina.

Il pulsante per sospendere a distanza i chip è visto come una misura estrema. Si dice che potrebbe essere incorporato nel silicio per impedirne l’uso in applicazioni dannose. Questo aiuterebbe le autorità di regolamentazione ad agire rapidamente nel caso in cui individuassero un uso pericoloso.

Tuttavia, i due autori avvertono che non si tratta di una soluzione perfetta. Un simile interruttore potrebbe essere preso di mira dai criminali informatici e sfruttato per usi abusivi dell’intelligenza artificiale.

Test di formazione

L’analisi solleva anche la possibilità che più parti coordinino gli sforzi per approvare compiti di formazione in sistemi di intelligenza artificiale potenzialmente rischiosi.. “Le armi nucleari utilizzano meccanismi simili, chiamati legami di azione permissiva”, spiega il rapporto.

Durante il Vertice sulla sicurezza dell’intelligenza artificiale, tenutosi a novembre nel Regno Unito, una serie di governi e di grandi sviluppatori si sono impegnati a collaborare per i futuri test dei loro modelli. I rappresentanti di OpenAI, Anthropic, Google, Microsoft, Meta e xAI hanno partecipato alle sessioni in cui è stata discussa la proposta.

In questo vertice è stato annunciato la creazione di un nuovo centro di test globale con sede nel Regno Unito. Il governo britannico ha dichiarato che sarà prestata particolare attenzione ai pericoli dell’intelligenza artificiale per la sicurezza nazionale e la società.